안녕하세요. 위기의코딩맨입니다.

벌써 부스트캠프 AI Tech 준비과정 4주차가 마무리되고 있습니다.

기대반 걱정반으로 시작했는데 벌써 4주차라니!!

지금까지 내용을 봤을땐, 제가 혼자 공부할땐 정확한 목적지를 몰라서 이거보고 저거보고 했던거 같은데

지금은 아 어떻게 가야하는구나 라는 길이 보이는 것 같습니다. ㅎㅎㅎ

해당 과정을 들으면서 유튜브에서 앤드류 응님의 강의도 같이 듣고있는데

이해하는데 도움이 되는 것 같습니다. 꼭 들어보시길 추천드려요!!

이제 4주차 내용을 정리해보도록 하겠습니다.

[ 4주차 ]

인공지능 수학에 대해서 아주 기초적인 학습을 진행했습니다.

- 벡터(vector) - 숫자를 원소로 갖는 리스트, 배열을 의미 (열 벡터,행 벡터).. 공간에서 한 점을 나타냄,, n차원공간 벡터는 같은 모양을 가지면 덧셈,뺄셈, 곱셈(성분곱) 연산이 가능

- 두 벡터의 덧셈은 다른 벡터로부터 상대적 위치이동을 표현 (AX = [ax1,ax2] .. 스칼라곱 : 길이 변화 np.array([1,2,3)] )

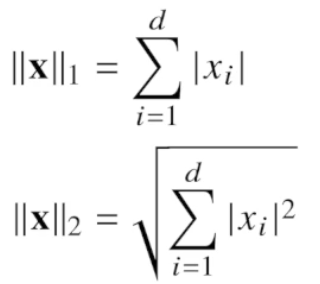

벡터의 노름(norm)

원점에서부터의 거리

- L1- norm - 각 성분의 변화량의 절대값을 모두 더함(abs,sum 함수이용), 라쏘

- L2-norm - 피타고라스 정리를 이용해 유클리드 거리를 계산(제곱 값, sum,sqrt 함수), 릿지

L1,L2 norm을 사용하는 이유는 norm의 종류에 따라 기하학적 성질이 달라져 목적에 따라 사용

두벡터사이의

두벡터사이의 각 (l2 에서만 가능 (inner, arccos 함수))

내적이란?

- 두 벡터의 각 성분끼리 곱의 합 하나의 벡터의 방향으로 나머지 하나를 투영 시킨 벡터와 다른 한벡터의 크기의 곱

- 스칼라 값으로 변환시키는 연산

- 내적은 정사영된 벡터의 길이와 관련

정사영이란?

점 A에 대하여 평면으로 내려서 평면에 점을 A’로 나타내는 점

행렬이란?

- 벡터를 원소로 가지는 2차원 배열

- 행[i]열[j] 순서로 인덱스를 갖고있습니다.

- 벡터와 마찬가지로 같은 모양을 갖고있으면 덧셈,뺄셈, 성분곱, 스칼라 곱 이 가능함

벡터가 공간에서 한점을 의미한다면 행렬은 여러 점을 나타냄

X = (xij) 표기도 사용

전치행렬(transpose matrix) - 행과 열의 인덱스가 바뀐 행렬을 의미 Xt = (xji)

행렬의 곱셈 - 열벡터 사이의 내적으로 가지는 행렬을 계산진행

역행렬( inverse matrix )

행과 열의 숫자가 같아야함, 0이 아니어야함

행과 열이 다를때 사용하는 방법

유사 역행렬( 무어-펜로즈 )

응용사용

- 연립방정식 np.linalg.pinv 함수 사용

- 선형회귀분석 np.linalg.pinv (y절편은 직접 설정해줘야함)함수 사용, Sklearn의 LinearRegression 함수(y절편을 자동으로 적용) 사용

경사하강법

- 극소, 극대, 최소, 최대 활용가능

- 미분(differentiation) - 변수의 움직이에 따른 함수값의 변화를 측정하는 도구, 접선의 기울기를 구함

- 한점의 기울기를 알면 어느 방향으로 움직여야 함수값이 증가하는지 감소하는지 확인 가능

선형모델 수식

- Softmax 함수 - 모델의 출력을 확률로 해석할수 있도록 변환해주는 연산, 분류 문제를 풀때, 선형모델과 소프트맥스 함수를 결합하여 예측

- softmax(o) = softmax(Wx+b)

- 학습경우 softmax 함수 사용, 추론인 경우에는 one-hot 벡터를 사용

- 활성함수 - sigmoid, tanh, ReLU

- 신경망 - 선형모델과 활성함수를 합성한 함수를 의미

- 다층 퍼셉트론 - 신경망이 여러층, 합성된 함수

- 다층으로 쌓는 이유? - 층이 깊을수록 목적 함수를 근사하는데 필요한 뉴런 숫자가 빨리 줄어들어 조금 더 효율적인 학습이 가능그러나 층이 깊다고 좋은 것은 아님, 초기화 등 다른 작업들이 늘어남

- 역전파 - 역순으로 순차적 계산을 진행

- 연쇄법칙기반 - 자동미분을 사용

여기까지 4주차 기본 적인 학습 내용입니다!

아주 기초적인 수학의 강의를 진행했습니다.

수학적으로 공부도 열심히 열심히 해야겠어요.. ㅎㅎㅎ

- 본 포스트의 학습 내용은 부스트클래스 <AI 엔지니어 기초 다지기 : 부스트캠프 AI Tech 준비과정> 강의 내용을 바탕으로 작성되었습니다

'[부스트캠프 AI Tech 준비과정] 2회차' 카테고리의 다른 글

| [부스트캠프 AI Tech 준비과정] 6주차 - 용어정리 (0) | 2024.05.30 |

|---|---|

| [부스트캠프 AI Tech 준비과정] - 5주차 인공지능 수학 2 (2) | 2024.05.23 |

| [부스트캠프 AI Tech 준비과정] - 3주차 (1) | 2024.05.13 |

| [부스트캠프 AI Tech 준비과정] - 2주차 (1) | 2024.05.03 |

| [부스트캠프 AI Tech 준비과정] - 1주차 (0) | 2024.04.29 |